谷歌利用AI芯片极大提高芯片设计周期 “区块链+AI”助力革命AI芯片及其产业技术突破

在2019年曾在上海举行的世界人工智能大会上,科技界各大神级人士表示,当前AI芯片发展看似火热,其实全球AI芯片产业尚处于“婴儿期”,未来发展仍需找准突破点。

从谷歌近期在AI芯片上的突破看看

谷歌AI,一种新的强化学习算法已经学会了优化组件在计算机芯片上的放置,使其更高效,更耗电。学习了一种新的强化学习算法,可以优化组件在计算机芯片上的放置,以使其更高效,更省电。

google AI在芯片设计上的突破来源于几个主要成果:

1、3D Tetris:芯片放置,也称为芯片平面布置图,是一个复杂的三维设计问题。它需要在受限区域中跨多层仔细配置数百个(有时甚至数千个)组件。传统上,工程师将手动设计配置,以最大程度地减少组件之间使用的电线数量,以提高效率。然后,他们使用电子设计自动化软件来模拟和验证其性能,单个平面图最多可能需要30个小时。

2、时滞:由于每个芯片设计需要投入时间,因此传统上认为芯片的使用寿命为两到五年。但是,随着机器学习算法的迅速发展,对新芯片架构的需求也在加速增长。近年来,几种优化芯片布局规划的算法试图加快设计过程,但在跨多个目标(包括芯片的功耗,计算性能和面积)的优化能力方面受到限制。

3、智能设计:为应对这些挑战,Google的团队研究人员Anna Goldie和Azalia Mirhoseini采用了一种新方法:强化智能学习。强化学习算法使用正反馈和负反馈来学习复杂的任务。因此,研究人员设计了一种所谓的“奖励功能”,以根据算法的设计性能对其进行惩罚和奖励。然后,该算法产生了成千上万的新设计,每一个设计都在不到一秒钟的时间内完成,并使用奖励函数对其进行了评估。随着时间的流逝,它收敛于以最佳方式放置芯片组件的最终策略。

4、验证:在使用电子设计自动化软件检查了设计之后,研究人员发现,该算法的许多楼层平面图的性能要优于人工工程师设计的平面图。研究人员说,它还向人类同行教授了一些新技巧。

5、生产线:在整个领域的历史中,AI(人工智能)的进步与芯片设计的进步息息相关。希望该算法将加快芯片设计过程,并导致新一代改进的体系结构,从而加速了AI技术在此领域的发展。

谷歌开源AI工具EfficientDet 利用较少计算资源实现高效物体检测

谷歌大脑和谷歌AI团队们开源AI工具EfficientDet。该工具可以使用较少的计算资源实现最先进的物体检测。该系统的创建者表示,与YOLO或AmoebaNet等其他物体检测模型相比,该系统与CPU或GPU一起使用时,还能实现更快的性能。

在进行另一项与物体检测相关的语义分割时,EfficientDet也表现出优异的性能。系统利用PASCAL使目标挑战数据集可视化,从而进行语义分割实验。

EfficientDet是EfficientNet的更新版本,该版本是去年为Coral单板计算机提供的一系列高级目标检测模型。

谷歌工程师在去年秋天首次发表的一篇论文中详细阐述了EfficientDet,但近期对其进行了修改和更新。

在该论文研究了用于物体检测的神经网络体系结构设计,论文中写道,“我们以优化准确性和效率为目标,希望开发一系列模型,以满足资源受限的应用需求。现有的缩放物体检测方法往往会牺牲准确性,或者会耗费大量资源,而EfficientDet使用成本更低、资源消耗更少的方法,同时对所有骨干网、特征网络和box/class预测网络的分辨率、深度和宽度进行统一缩放,将物体检测部署在边缘或云上。”论文还写道,“在机器人和自动驾驶汽车等诸多现实世界应用中,模型尺寸和延迟受到高度限制,而巨大的模型尺寸和昂贵的计算成本导致上述模型很难部署。考虑到这些现实约束,目标检测模型的效率变得越来越重要。”

EfficientDet的优化灵感来自关于EfficientNet的研究,提出了骨干网和特征网的联合复合缩放方法。其中,双向特征金字塔网络(BiFPN)作为特征网络,经过ImageNet预训练的EfficientNet作为骨干网络。

EfficientDet通过删除只有一个输入边缘的节点来优化跨尺度连接,从而创建更简单的双向网络。

EfficientDet还依赖单级探测器范式,这是一种以效率和简单著称的物体探测器。论文写道,“我们建议,在特征融合时为每个输入特征增加额外权重,让网络了解每个输入特征的重要性。”

AI芯片技术突破点的研究问题

目前主流 AI 芯片的核心主要是利用 MAC(Multiplier and Accumulation,乘加计算)加速阵列来实现对 CNN(卷积神经网络)中最主要的卷积运算的加速。

算力是人工智能发展的关键因素之一,随着深度学习算法的普及应用,人工智能对算力提出了更高要求,传统的CPU架构无法满足深度学习对算力的需求,因此,具有海量数据并行计算能力、能够加速计算处理的人工智能芯片应运而生。

根据《2018人工智能芯片研究报告(AMiner)研究报告第十四期》中趋势篇提到,这一代 AI 芯片主要有如下 3 个方面的问题:

(1)深度学习计算所需数据量巨大,造成内存带宽成为整个系统的瓶颈,即所谓“memory wall”问题。

(2)与第一个问题相关,内存大量访问和 MAC阵列的大量运算,造成 AI芯片整体功耗的增加。

(3)深度学习对算力要求很高,要提升算力,最好的方法是做硬件加速,但是同时深度学习算法的发展也是日新月异,新的算法可能在已经固化的硬件加速器上无法得到很好的支持,即性能和灵活度之间的平衡问题。

下一代 AI 芯片将有如下的几个发展趋势

-

趋势一:更高效的大卷积解构/复用

-

趋势二:更低的 Inference 计算/存储位宽

-

趋势三:更多样的存储器定制设计

-

趋势四:更稀疏的大规模向量实现

-

趋势五:计算和存储一体化

芯片的突破,应该是整个产业的一体化新兴技术融合解决方案

在整个下一代芯片产业革新突破的时候,是区块链技术完美地提供生产关系支持。

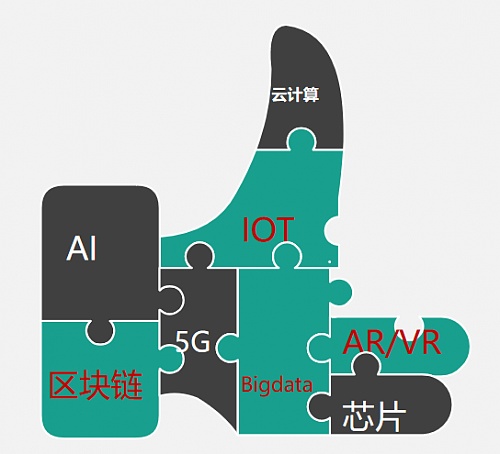

区块链的准确定义为分布式记账技术,是一门为未来准备的技术。既然他的职责是财务记账职责,不与其他技术结合,其价值将无法凸显;而下一代新兴技术AI/大数据/云计算/物联网/5G等,除了彼此紧密结合外,万物互联后,机器与机器之间的协作和报酬激励,若不采用区块链技术作为智能物种之间的生产关系支撑,将无法实现。最终这些技术的相互融合,将完成第四次工业革命,最终解放人类的大脑。

第四次工业革命=区块链+AI+大数据+云计算+物联网+5G+芯片+AR/VR,这些技术将融合发展,相辅相成,最终形成一体化解决方案。而在这些颠覆性技术里,区块链与芯片产业是基础设施,芯片产业为下一代技术提供算力支持,而区块链为下一代技术们提供生产关系支持。我国对芯片产业重要性的认识程度很高,对区块链产业重要性的认知也急需提高。

下面我们来看看,各个技术融合后,将如何解决困扰各个技术产业的问题。作为一门负责生产关系的技术,我们重点以区块链为纽带进行分析。

A)区块链+AI+大数据+下一代芯片+边缘计算

区块链同态加密算法可以确保密文数据亦可被AI计算,解决数据隐私和所有权问题;

区块链MPC多方安全计算,可以确保大数据提供方、人工智能算法提供方安全的基础上,进行多方协作计算,共享计算结果,并采用区块链可编程数字货币、智能合约,进行激励分配。我们都知道,人工智能公司最缺的就是数据和算法,为什么不可以共享数据和算法呢?这里面就缺一个安全靠谱的技术分配机制;

下一代芯片+5G+边缘计算,确保计算能够及时处理和响应。

B) 区块链+大数据

区块链哈希函数确保数据不被篡改或篡改后可发现,这样可以确保数据的真实性;

区块链非对称加密确保数据的脱敏性,防止泄露个人隐私数据曝光;

区块链零知识证明确保加密数据的可验证性;

智能合约及可编程数字货币确保大数据交易可以自动执行以及价值互换;

C)区块链+云计算+5G

区块链通证激励机制和密码学相关算法,为集中式云计算中心演变到边缘计算提供无许可、安全的接入和退出自动激励机制,利用技术力量释放社会计算资源;

D)区块链+AR/VR+5G+下一代芯片+边缘计算

区块链技术可以验证VR/AR世界中身份真伪,智能合约可以对其资产进行确权和交易;

E)区块链+物联网+5G

未来万物互联,万物有脑。第四次工业革命的最终成果,将以智能机器新物种的成熟为标志。智能机器物种将与人类并存。区块链点对点技术协议以及智能合约、可编程数字货币技术,与物联网及5G结合,将实现智能机器物种们:设备网络化、数据化、数据资产化、资产交易化、交易金融化。智能机器物种们将通过区块链,进行数据交易协作,MPC算法协作及数字货币激励。

区块链是基于代码信任而产生的一种分布式记账技术,其代码信任而产生的共识机制,带来了全新的货币体系和金融体系,显然,这种基于代码的信任体系并不是为由细胞组成的人类而准备的,而是为同样由代码构成的未来智能机器新物种们而准备的协作、分配、金融等一些列智能机器社会治理新体系。

这个基于代码信任而构建金融、经济、协作、治理体系,是为未来智能机器人而准备的,它将与人类世界现有金融经济社会治理体系二元发展,AI机器人的到来为整个AI芯片技术突破和产业革新必定提供最大促进作用。

来源:区块新看点

- 免责声明

- 世链财经作为开放的信息发布平台,所有资讯仅代表作者个人观点,与世链财经无关。如文章、图片、音频或视频出现侵权、违规及其他不当言论,请提供相关材料,发送到:2785592653@qq.com。

- 风险提示:本站所提供的资讯不代表任何投资暗示。投资有风险,入市须谨慎。

- 世链粉丝群:提供最新热点新闻,空投糖果、红包等福利,微信:juu3644。

链百家

链百家